连续学习能力是下一代AI的重要标志

导读:近日,在ACM(Association of Computing Machinery)的通讯期刊上的一篇题为《Lifelong Learning in Artificial Neural Networks》的文章十分引人注目。

“在未来几年,我们今天很多的AI由于没有终身学习能力都不会被认为是AI。”

“DARPA(美国国防高级研究计划局)的终身学习机器计划不是在寻求渐进式改进,而是寻求机器学习的新范式。”

近日,在ACM(Association of Computing Machinery)的通讯期刊上的一篇题为《Lifelong Learning in Artificial Neural Networks》的文章十分引人注目。虽然基于深度学习的AI近年来得到快速发展,但也正面临着新的巨大挑战。对于不断变化着的环境,当今的AI技术显得无所适从,在学习新内容时会产生“灾难性遗忘”现象-严重遗忘掉已经学习过的内容。人们必需对AI系统重新使用新的数据集(包含旧的)进行训练,导致在许多实际场景中无法使用或使用代价极大。自动驾驶就是一个很好的例子,我们不可能知道将会遇到怎样的新场景。但是,人的智能,甚至是动物的智能,却有明显的自适应能力,能连续不断地学习,而不至于产生“灾难性遗忘”现象,甚至具有终身学习的能力。

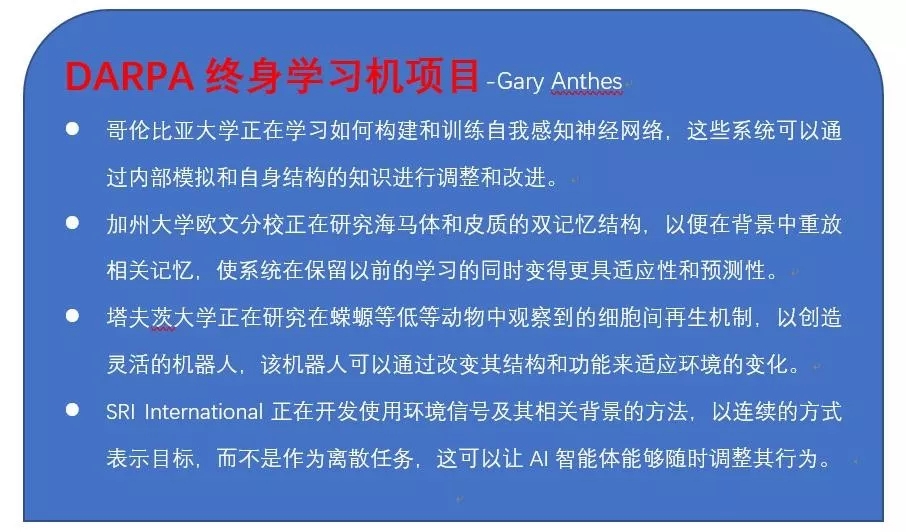

近两年来,AI中的连续学习(Continual Learning)也被称为终身学习(Lifelong Learning)问题得到人们的高度重视,产生了一些研究成果。目前看来,灾难性遗忘的根源之一很可能与AI中普遍使用的误差反向传播(BP)算法有关,因为此算法在修改权重时,原则上会对所有的权重进行修改,是一种全局性的修正算法。目前,为使得“灾难性遗忘“得到缓解,一些提出的连续学习方法大多采用保护已经学习过的权重和保留小部分学习过的内容(记忆)。文章中提到的Hebbian算法则是一种局部的修正算法,是已经存在了70年的由神经心理学家Donald Hebb提出对神经系统如何学习的粗糙描述。如今,我们对大脑有了相当深入的了解。从大脑的角度去看连续学习的功能可以获得对解决“灾难性遗忘“问题的重大启示。去年中科院自动化所余山研究员的团队受大脑前额叶功能的启发,也在连续学习这一领域取得很好的成果,并获得了清华大学2018年类脑计算比赛的特等奖。从ACM这篇文章中公开的美国国防高级研究计划局的终身学习机(L2M)计划看,其目标已经不是简单地提升准确率、缓解“灾难性遗忘“问题,而是从更为仿生类脑的角度(例如模拟大脑海马体和皮质的双记忆结构)出发,实现本质上的突破,达到类人的终身学习能力。

当前的AI具有很好的感知能力,但缺乏连续学习以及许多认知方面的能力。在前些天ACM的图灵讲座上,Geoffrey Hinton和Yann LeCun分别做了题为《深度学习革命》、《深度学习革命:续集》的精彩演讲(可看新智元中文报导https://mp.weixin.qq.com/s/nysTQzqGhcPVP9eXchreqQ,视频 https://fcrc.acm.org/turing-lecture-at-fcrc-2019)。有关神经网络的未来,Hinton认为:几乎所有人工神经网络只使用两个时间尺度:对权重的缓慢适应和神经活动的快速变化。但是突触在多个不同的时间尺度上适应。它可以使快速权重(fast weight)进行short-term memory将使神经网络变得更好,可以改善优化、可以允许真正的递归。

从脑科学的角度不难看到人类连续学习能力不但涉及到感知,而且更为重要的是记忆和在记忆基础上的各种认知功能。所以,把终身学习能力作为研究的目标和抓手,并更重视采用革命性的方法实现本质上的突破,将能推动具有连续学习能力和认知功能的下一代AI早日到来。让我们共同努力并拭目以待!(完)

附译文:

人工神经网络的终身学习

-使系统快速并连续适应的新方法

王晔 译 ,曹立宏 校

中国传媒大学,脑科学与智能媒体研究院

2019.6.25

在过去的几十年中,基于机器学习的人工智能(AI)技术表现不凡,在某些能力上接近甚至超越人类专家。相关的例子包括图像识别、语言翻译以及在围棋游戏中的表现。

这些应用采用了由数以百万的权重连接的大规模的人工神经网络。人工神经网络虽说是模仿生物大脑的结构和工作机制,但关键的一点并未模仿成功:它们并不能像动物一样随时随刻连续不断地学习。这些人工神经网络一旦被设计好,写好程序,并被开发者训练好,它们便无法适应新的数据和新的任务的学习,而必需重新训练(新老数据、任务同时一起),这往往需要耗费大量的时间。

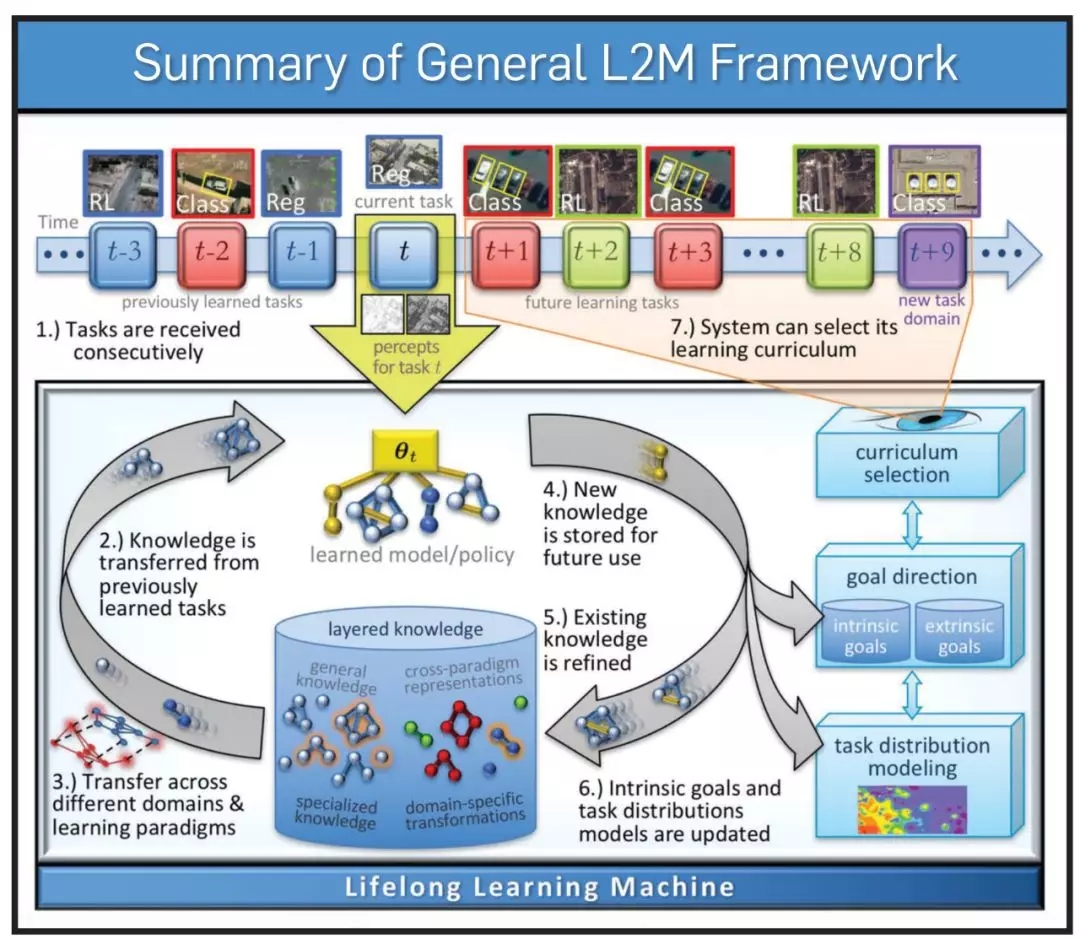

图 1、DARPA终身学习机(L2M)计划旨在开发学习系统,通过额外的经验不断改进,并快速适应新的条件和动态环境。

AI系统的实时适应性是目前的一个研究热点。比如,Uber公司的计算机科学家去年发表了一篇论文,论文中描述了一种在神经网络中引入“可塑性”的方法。在一些包括图像识别和迷宫探索的测试场景中,研究者展示了这个之前训练好的神经网络可以在不需要额外训练的情况下快速、高效的适应新的任务。

“通常的方法是花很长的时间,用大量的(百万或上亿)样本去训练网络”,文章的主要作者,Uber的计算神经科学家Thomas Miconi说到。“但这不是我们的工作方式。我们可以快速学习,通常只需要看一遍就可以学会。有了突触可塑性,我们大脑中的连接可以自动的发生改变,这使得我们可以快速的形成记忆。“

在过去的60多年中,神经网络都是通过有标记的数据集来训练节点(人工神经元)之间的连接权重。这样的训练经常是通过一种被称为反向传播的方法来实现的,在反向传播中,系统计算突触输出的误差并将其反传到神经网络的各层中。目前,大部分深度学习系统包括Miconi的测试系统依然使用梯度下降进行反向传播来作为优化策略。

以此为出发点,Miconi使用了由神经心理学家Donald Hebb于1949年提出的Hebbian学习规则。Hebb认为,两个神经元的电活动越同步,它们的连接就越强。

通过在网络中加入Hebbian可塑性,基于三个在概念上非常简单的参数,网络就拥有了一种“元学习”的能力,即它学习如何学习。在训练过程中,系统会建立神经元之间传统的固定权重。这些神经元还拥有被称为Hebbian痕迹的可塑的权重,这些权重会随着它遇到新的数据而终身改变。这些Hebbian痕迹可以用不同的方式计算,一个简单的例子是由突触前和突触后活动乘积的滑动平均来决定。

Hebbian痕迹本身还由第三个被称为可塑性系数的固定参数所加权。这样,在任一时刻,两个神经元之间的有效连接权重是可塑性系数乘以固定权重和Hebbian痕迹之和。有了这三个参数的值,每个连接的强度就处于完全固定、完全可变或二者之间。

“这是一项重要的工作”,并没有参与到Uber这项工作中的卡内基梅隆大学的计算生物学家Ziv Bar-Joseph提到。“他们使用了生物中广为人知的规则并说明这个规则对人工神经网络有积极的作用。”然而,现在说这个方法会对AI的大量主流应用起重要作用仍为时尚早,他说到。

对于目前大多数AI系统而言,Bar-Joseph说:“你去优化,优化,再优化,就是这样。如果你得到了新的数据,你可以重新训练这个系统,但你没法让这个系统去适应新数据。”比如,他提到,一个神经网络可能已经被训练成可以很好完成汽车分类任务,但当这个系统看到一款新车(比如特斯拉)时,系统就会出错。“你想让它快速的认识这辆新车,而不想通过需要花费数天到数星期的时间重新训练它。而且,你怎么知道新的事情已经发生了呢?”

可以随时学习的AI系统并不新鲜。在“神经进化”中,网络通过诸如用试错法达到事先指定的目标(比如赢一盘棋)的算法来进行自我更新。它们不需要有标记的训练样本,只需要定义好什么是“成功”就行了。“它们只是不断的试错”,Uber的Miconi说到。“这很强大,但却是非常慢且随机的过程。如果你看到了一个新事物,你得到了一个告诉你朝那个方向调整你的权重的误差信号,事情就好多了。这也是反向传播的做法。”

Miconi的想法只代表了一种AI中自我学习的方法。美国国防部正在推行更为广泛的实验方法(突触可塑性只是其中的一部分)来确保防御系统更加的精确、反应迅速和安全。美国国防高级研究计划局(DARPA)已经构建了一个终身学习机(L2M)计划,该计划主要有两个方面的侧重,一方面侧重于完整系统及其组件的开发,另一方面侧重于探索生物有机体中的学习机制并将其转化为计算过程。其目标是让AI系统能够“在任务中学习和改进,把前面学到的技能和知识应用到新环境中,弥补先天系统的限制,并增强自动分配的安全性,”DARPA在其官网中这样写到。“我们不是在寻求渐进式改进,而是寻求机器学习的新范式。”

利用Hebbian可塑性的Uber的工作对于神经网络的终身学习而言是有希望的一步,DARPA L2M计划的创始人及马萨诸塞大学阿默斯特分校计算机科学教授Hava Siegelmann说到。“没有终身学习,自动驾驶汽车永远不会安全,”她说到。但这只是实现这一目标众多步骤中的一步。“这绝对不是故事的结局,”她说。

DARPA为终身学习定义了五个“支柱”,突触可塑性属于其中的第一个。五大支柱是:不断更新记忆,不会造成灾难性遗忘;重组记忆,重新排列和重新组合先前学到的信息以用于未来的行为;上下文感知和基于上下文的系统行为调节;通过内部游戏、自我意识和自我模拟来采纳新行为; 安全和保障,认识到某些事情是否危险并相应地改变行为,并通过强有力的约束来确保安全。

Siegelmann引用智能假肢作为这些技术应用的一个例子。她说,智能假肢的控制软件可以通过其制造商提供的传统反向传播方法进行训练,然后接受其用户的独特习惯和特征的训练,并最终能够快速适应以前从未见过的情况,例如:结冰的人行道。

Siegelmann是一位计算神经科学家,她说终身学习多年来一直是人工智能研究者的目标,但最近才取得了重大进展,这得益于计算机能力的提高,新的理论基础和算法,以及对生物学的更好理解。“在未来几年内,我们今天所谓的人工智能很多都不会被认为是人工智能,因为它没有终身学习的能力,” 她预测道。

相比于当前的测试系统,Miconi的团队目前正致力于让学习更加动态和复杂。实现这一目标的一种方法是使可塑性系数(现在是固定的)在系统的整个生命周期内自身可变。“每个连接的可塑性可以由网络本身在每个点确定,”他说。他还说到,这种很可能发生在动物大脑中的“神经调节”可能是让AI系统做出最灵活决策的关键一步。