一种新型芯片:将进一步拓展人工智能的发展

导读:一种名为NeuRRAM的节能芯片修复了一个旧有的计算机设计缺陷,可在较小的设备上运行大规模的人工智能算法,达到与相当耗能的数字计算机同样的精度。

一种名为NeuRRAM的节能芯片修复了一个旧有的计算机设计缺陷,可在较小的设备上运行大规模的人工智能算法,达到与相当耗能的数字计算机同样的精度。

数字计算与神经形态计算纠缠在一起的解决方案

我们许多人知道,人工智能近年来得到长足的发展,取得越来愈广泛的应用。但是,有个发展的瓶颈,那就是人工智能算法不可能以其目前的速度继续增长。像深度神经网络这样的算法,它受到大脑的启发,多层人工神经元通过称为权重的数值相互连接,其规模在日益庞大。如今,硬件的改进已经跟不上运行这些大规模算法所需的巨大内存和处理能力的步伐。

而且,即使可以不断扩大硬件规模以满足人工智能的需求,还有一个问题是:在传统计算机上运行会浪费大量的能源。运行大型人工智能算法所产生的高碳排放已经对环境造成有害影响,而且随着算法的日益庞大,情况只会变得更糟。

一种被称为神经形态计算的解决方案,从生物大脑中获得灵感,创造出节能的设计。这些芯片可以在节约能源方面超过数字计算机,但问题是:缺乏运行一个相当大的深度神经网络所需的计算能力。所以这个神经形态计算的解决方案在提出后一直没有受到重视。

这种情况在今年8月发生了显著变化,发表在《自然》杂志上的论文中,一个由斯坦福大学领导的国际研究团队揭示了一种新的神经形态芯片,其计算能力超过了数字计算机:

论文第一作者、万伟尔(Weier Wan)毕业于斯坦福大学,博士期间师从论文资深作者、斯坦福大学黃汉森(H.-S. Philip Wong)教授,和论文资深作者、加州大学圣地亚哥分校格特·考文伯格 (Gert Cauwenberghs))教授。

黃汉森教授于2004年加入斯坦福大学担任电气工程教授。从1988年到2004年,在 IBM T.J. 沃森研究中心从事研究。 从2018年到2020年,他从斯坦福大学休假,在全球最大的半导体代工厂台积电担任研究副总裁,自2020年起继续担任台积电首席科学家。

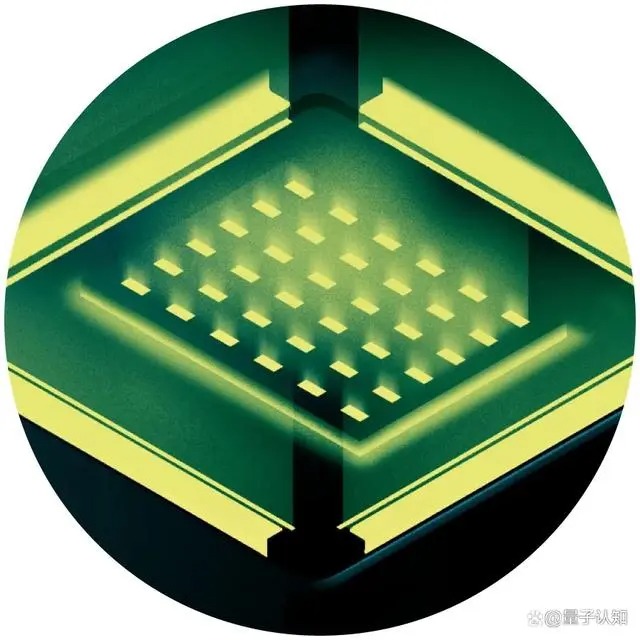

这篇论文描述了一款名为“NeuRRAM”的AI芯片,这款芯片采用了基于阻变式存储器(Resistive RAM,RRAM)的“存算一体”架构来减少数据流动。它在支持多种人工智能应用的同时,大幅提升了能效,使得在边缘设备中实现复杂的人工智能任务成为可能。

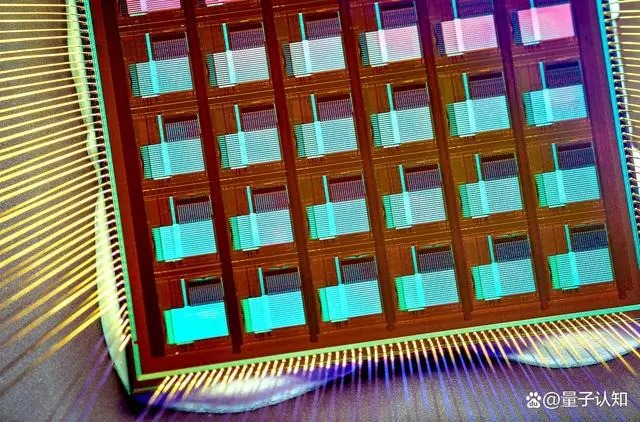

这种新型的神经形态芯片包含300万个存储单元和数千个内置在其硬件中的神经元,以运行算法。该研究的阻变存储器与以前的不同,NeuRRAM被编程为以模拟方式运行,以节省更多的能源和空间。虽然数字存储器是二进制的,存储1或0,但NeuRRAM芯片中的模拟存储器单元可以沿着一个完全连续的范围存储多个值。这使得该芯片能够在相同的芯片空间内存储来自大规模人工智能算法的更多信息。

因此,在图像和语音识别等复杂的人工智能任务上,这种新芯片的性能不亚于数字计算机,该研究声称它的能效高达1000倍,这为微型芯片在以前不适合人工智能的小型设备,如智能手表和手机中运行越来越复杂而高级的运算提供了可能性。

学界评论这一研究成果说:"这篇论文相当独特。它在不同的层面做出了贡献:在设备层面、在电路架构层面、以及在算法层面。"

创造新的记忆

在数字计算机中,当运行人工智能算法时浪费的大量能量是由一个简单而普遍存在的设计缺陷造成的,它使每一次计算都变得低效。通常情况下,计算机的内存,即保存计算过程中的数据和数值,被放置在远离处理器的主板上,而处理器是进行计算的地方。

最近从斯坦福转到了人工智能物联网( (AIoT) )公司Aizip的万伟尔解释说,对于流经处理器的信息来说,"这有点像你花了8个小时的通勤时间,但你却做了2个小时的工作。"

NeuRRAM芯片可以在其内存中运行计算,它在内存中存储的数据不是传统的二进制数字,而是模拟光谱。

用新的一体式芯片来解决这个问题,把内存和计算放在同一个地方,方式很直接。它也更接近我们的大脑可能处理信息的方式,许多神经科学家认为我们大脑的计算是发生在神经元群中,而记忆是在神经元之间的突触加强或减弱其连接时形成的。但问题是:开发这种设备绝非易事,因为目前的记忆形式与处理器中的技术不兼容。

几十年前,计算机科学家们开发了这种创造新芯片的材料,这些芯片在存储内存的地方进行计算,这种技术被称为内存计算(compute-in-memory)。鉴于传统的数字计算机性能还非常好,这些想法几十年来被忽视了。

1964年,斯坦福大学的研究人员发现他们可以操纵某些被称为金属氧化物的材料,以打开和关闭其导电能力。这很重要,因为材料在两种状态之间切换的能力为传统的记忆存储提供了支柱。通常,在数字存储器中,高电压状态对应于1,而低电压对应于0。

为了让阻变式存储器切换状态,需要在连接到金属氧化物两端的金属电极上施加一个电压。通常情况下,金属氧化物是绝缘体,这意味着它们不导电。但是,如果有足够的电压,电流就会积累起来,最终穿过材料的薄弱点,形成一条通往另一侧电极的路径。一旦电流突破,它就可以沿着该路径自由流动。

黃教授解释说,这个过程犹如闪电。当云层中积累了足够的电荷时,它很快就会找到一条低电阻的路径,然后闪电就会出现。但与闪电不同的是,闪电的路径会消失,而通过金属氧化物的路径仍然存在,这意味着它可以无限期地保持导电。而且有可能通过对材料施加另一个电压来擦除导电路径。因此,可以在两种状态之间切换阻变式存储器,并使用它们来存储数字存储器。

人工智能内存中的计算芯片

十多年来,像黃汉森这样的研究人员一直致力于建立阻变式存储器技术,使其能够可靠地处理高功率的计算任务。大约在2015年,计算机科学家开始认识到这些节能设备在大型人工智能算法方面的巨大潜力,而这些算法正开始起飞。那一年,加州大学圣巴巴拉分校的科学家们表明,阻变式存储器可以做的不仅仅是以一种新的方式存储内存,还可以自己执行基本的计算任务,包括在神经网络的人工神经元内发生的绝大多数计算,这些计算是简单的矩阵乘法任务。

在NeuRRAM芯片中,硅神经元被内置到硬件中,而阻变式存储单元存储权重代表神经元之间连接强度的值。而且,由于NeuRRAM存储单元是模拟的,它们所存储的权重代表了设备在低电阻状态和高电阻状态之间切换时发生的全部电阻状态范围。这使得能源效率甚至高于数字阻变式存储所能达到的水平,因为这种芯片可以并行运行许多矩阵计算,而不是像数字处理版本那样一个接一个地同步进行。

但是,由于模拟处理仍然落后于数字处理几十年,仍有许多问题需要解决。其中一个问题是,模拟阻变式存储器芯片必须异常精确,因为物理芯片上的不完善会带来变化和噪音。对于只有两种状态的传统芯片来说,这些不完善的地方几乎没有那么重要。这使得模拟阻变式存储器运行人工智能算法的难度大大增加,因为如果阻变式存储器的导电状态每次都不完全相同,那么识别图像的准确性将受到影响。

黃教授解释说,"当我们看一个照明路径时,每次都是不同的,因此,作为一个结果,阻变式存储器表现出一定程度的随机性,每次你对它们进行编程时都略有不同。" 黃的团队证明了阻变式存储器可以存储连续的人工智能权重,并且仍然像数字计算机一样准确。

黃汉森(左)和万伟尔(右)帮助开发了一种新的计算机芯片,可以以前所未有的效率运行巨大的人工智能算法。

必须解决的另一个主要问题涉及支持多样化神经网络所需的灵活性。在过去,芯片设计者不得不将微小的阻变式存储器排在一个区域,紧挨着较大的硅神经元。阻变式存储器和神经元是硬接线,没有可编程性,所以计算只能在单一方向上进行。为了支持双向计算的神经网络,额外的电线和电路是必要的,增加了能源和空间需求。

因此,黃的团队设计了一个新的芯片架构,其中阻变式存储器和硅神经元被混合在一起。这一设计上的小变化减少了总面积并节省了能源。

瑞士联邦理工学院苏黎世分校的神经形态学科学家Melika Payvand评价说:"我认为[这种安排]非常漂亮。""我绝对认为这是一项开创性的工作。"

近年来,黃的团队与合作者合作,在NeuRRAM芯片上设计、制造、测试、校准和运行AI算法。他们确实考虑过使用其他新兴的存储器类型,这些存储器也可以用于内存计算芯片,但阻变式存储器具有优势,因为它在模拟编程方面具有优势,而且它相对容易与传统计算材料集成。

学界评论说:他们最近的成果代表了第一个可以运行如此大型和复杂的人工智能算法的阻变式存储器芯片,这一壮举以前只在理论模拟中实现。""当涉及到真正的硅时,这种能力没有了。"这项工作是开创性的展示。""数字人工智能系统是灵活和精确的,但效率却低了好几个数量级。现在,他们的灵活、精确和节能的模拟阻变式存储器芯片"首次弥补了这一差距"。

扩展规模

该团队的设计保持了NeuRRAM芯片的微小,只有指甲盖大小,同时包含了300万个可作为模拟处理器的阻变式存储器。而且,虽然它至少可以像数字计算机那样运行神经网络,但该芯片也(而且是第一次)可以运行在不同方向上进行计算的算法。这一芯片可以向阻变式存储器阵列的行输入电压,并从列读取输出,这是阻变式存储器芯片的标准,但也可以从列向行逆向操作,因此可以用于以不同方向的数据流进行操作的神经网络。

现在尺度是一个问题。目前最大的神经网络包含数十亿的权重,而不是新芯片中的数百万。黃汉森计划通过将多个NeuRRAM芯片堆叠在一起来扩大规模。

在未来的设备中保持较低的能源成本,进一步缩小其尺寸,也同样重要。实现这一目标的方法之一是更紧密地模拟大脑,采用真正的神经元之间使用的通信信号:电脉冲。当细胞内外的电压差达到一个临界阈值时,它是由一个神经元向另一个神经元发射的信号。

就目前而言,该团队在NeuRRAM芯片上运行大型人工智能算法时所完成的能源效率创造了新的希望,即内存技术可能代表人工智能计算的未来。也许有一天,甚至能够与人类大脑的860亿个神经元和连接它们的数万亿个突触相媲美,而又相当节能。